本文介绍了黑芝麻智能视觉与4D毫米波雷达前融合算法,通过多模态特征对齐和时序建模,显著提升逆光、遮挡等复杂场景下的目标检测精度,增强辅助驾驶安全性。

随着辅助驾驶技术逐步融入日常生活,其安全性成为社会关注焦点,尤其在复杂交通场景中目标检测的稳定性和准确性成为行业研究核心。如何提升目标检测的准确,稳定性,成为了行业内必须探讨和研究的议题。不同目标识别传感器的选择以及其配套的识别方案,对目标检测精度有着巨大的影响。

目标识别传感器选择

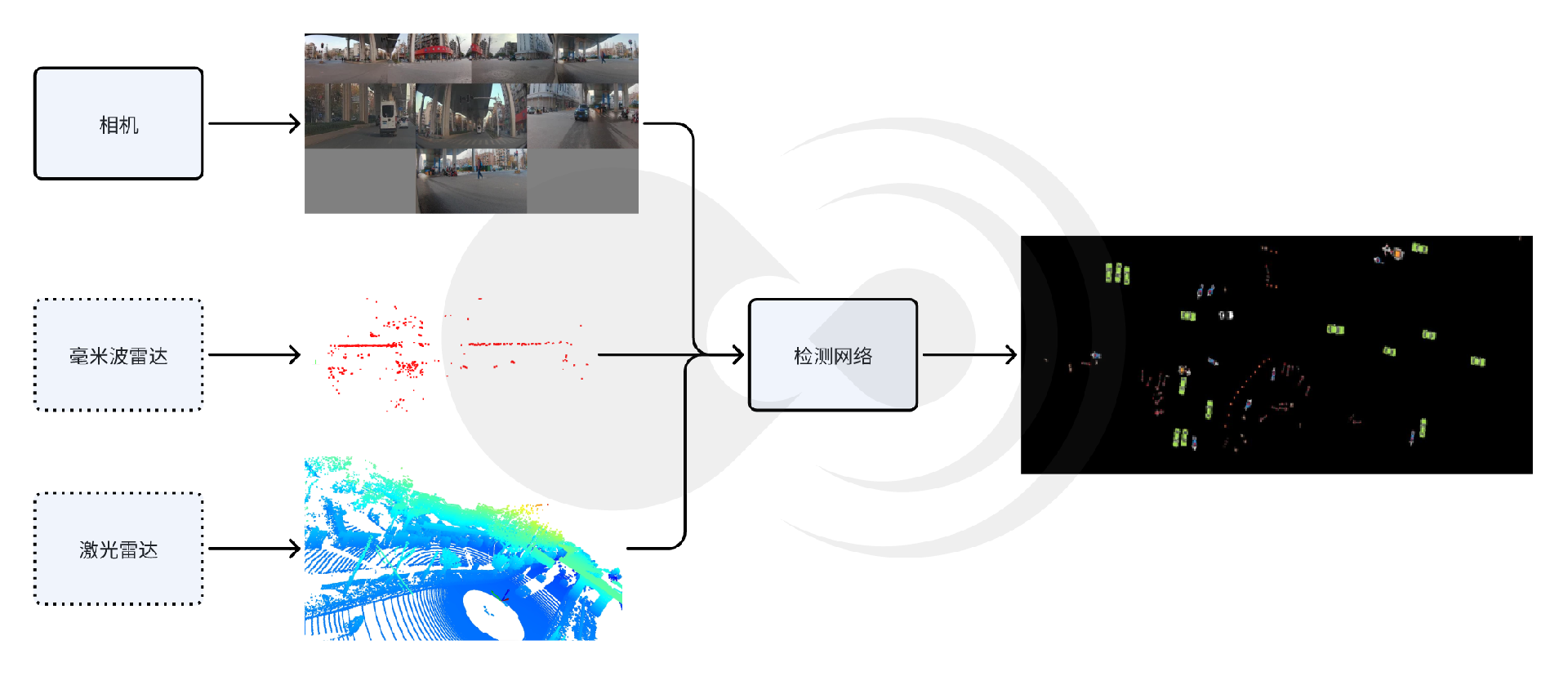

多传感器目标检测示意图

目前主流的传感器感知方案包括纯视觉、激光雷达与相机融合以及新兴的毫米波雷达与相机融合,这三种方案各有优劣。

纯视觉的检测方案因其方便部署,硬件成本较低,具有较高分辨率等优势,被广泛应用于目前各大主流辅助驾驶平台中。然而,由于纯视觉方案受光照、天气等因素的影响较大,在夜间、逆光、雨雪雾等场景下,性能存在一定的局限性,且图片无直接的深度信息,需要依赖单目/双目估计的方法估算目标距离信息,3D检测精度有限;

相机激光雷达融合的方式,具有高精度3D感知,全天候工作的特点,受到业界高端车型的青睐。但由于激光雷达硬件昂贵,量产车型成本压力大,且在极端天气下,激光束可能会发散,从而影响点云质量,导致检测精度下降;

相机毫米波雷达融合的方案,毫米波穿透性强,在雨雾、沙尘等恶劣天气下仍可稳定工作,具有全天候工作精度较高的优秀表现。此外,毫米波雷达硬件成本适中,其成本仅为激光雷达的1/3以下,且产业链成熟,适合规模化量产。

基于以上特点,毫米波雷达相机融合的方案成为了行业新趋势。基于AI的融合算法,如前融合点云投影、后融合目标级关联等逐步成熟。

行业毫米波雷达相机融合方案

辅助驾驶行业内,4D毫米波雷达相机融合方案正在加速落地,各头部车企都有相应的布局和应用:

OEM厂商A:采用多模态融合架构,结合摄像头、4D成像雷达和激光雷达。通过前融合和中融合的方式,融合多模态信息。前融合于原始数据层进行融合,通过时空同步算法对齐雷达点云与图像像素信息,提升三维重建精度;中融合于特征级进行融合,使用ResNet-FPN网络提取图像“占用体积”特征,并将该特征与之前的特征相融合,产生4D占用网络,最后使用反卷积获得体积及时序等反馈,从而实现动态以及静态的障碍物感知,增强目标属性的预测。多传感器互补,具有高冗余性,且因为有雷达高度信息的加持,可以覆盖长尾场景,如施工路段等,但多传感器融合需要高算力支持,成本较高;

OEM厂商B:整合摄像头、激光雷达、毫米波雷达、超声波雷达等传感器的数据,构建360°的环境感知能力。采用主流的BEV+Transformer技术方案,BEV负责将收集到的信息进行前融合,Transformer负责对信息进行处理。除此之外,叠加激光融合的GOD网络,摆脱大量人工规则的约束,可以稳定识别小狗、减速带和车库闸门等,对于路旁异常出现的水管水柱也能进行避让;

传统Tier1厂商A:使用毫米波雷达相机融合的方案,聚焦模块化设计,采用JPDA(联合概率数据关联)算法,将雷达目标与视觉检测框通过IoU(交并比)和速度一致性匹配,提升目标跟踪稳定性;通过eCalib工具实现雷达与相机的时空同步,误差控制在+-5cm内,但该类的传统规则融合算法迭代慢,泛化性差,较难支持高等级辅助驾驶需求。

黑芝麻智能融合团队,采用了4D毫米波雷达和相机融合的方案,结合深度学习模型,提升了雨雾雪、黑夜、逆光等极端天气和场景下目标检测的准确性和稳定性,改善了异形车、遮挡目标等物体检测的识别率,优化了上下坡、匝道等三维空间存在变化的场景中目标测距测速的精确性,显著提升了辅助驾驶的安全性与可行性。

黑芝麻智能4D毫米波雷达相机融合方案

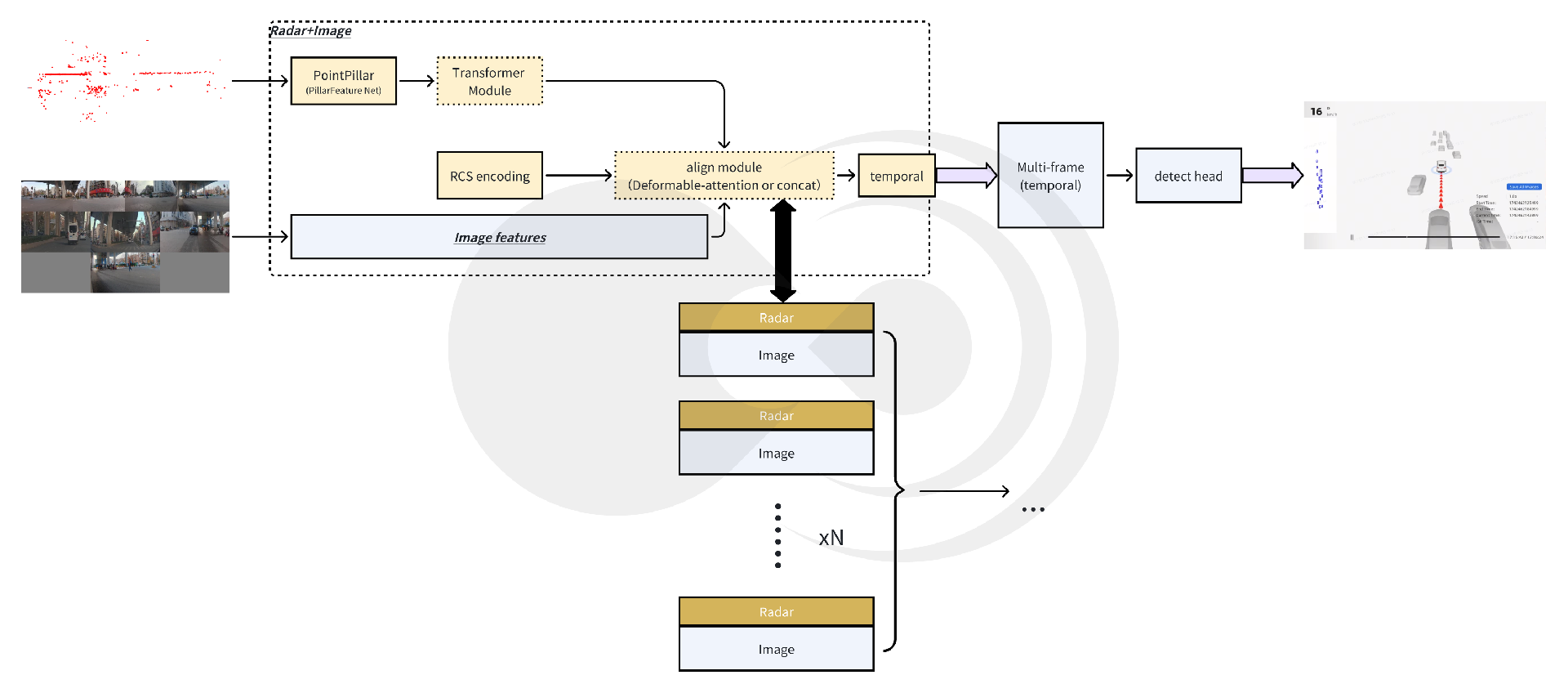

黑芝麻智能4D毫米波雷达相机融合方案,在BEV纯视觉目标检测方案基础上,添加4D毫米波雷达特征提取分支。4D毫米波雷达点云在经过特征提取分支后,与图像分支提取的图像特征对齐并融合,组成时序信息,再经过目标head,输出目标相关的信息,其总体框架如下图所示:

黑芝麻智能4D毫米波雷达相机融合框架示意图

4D毫米波雷达特征提取模块

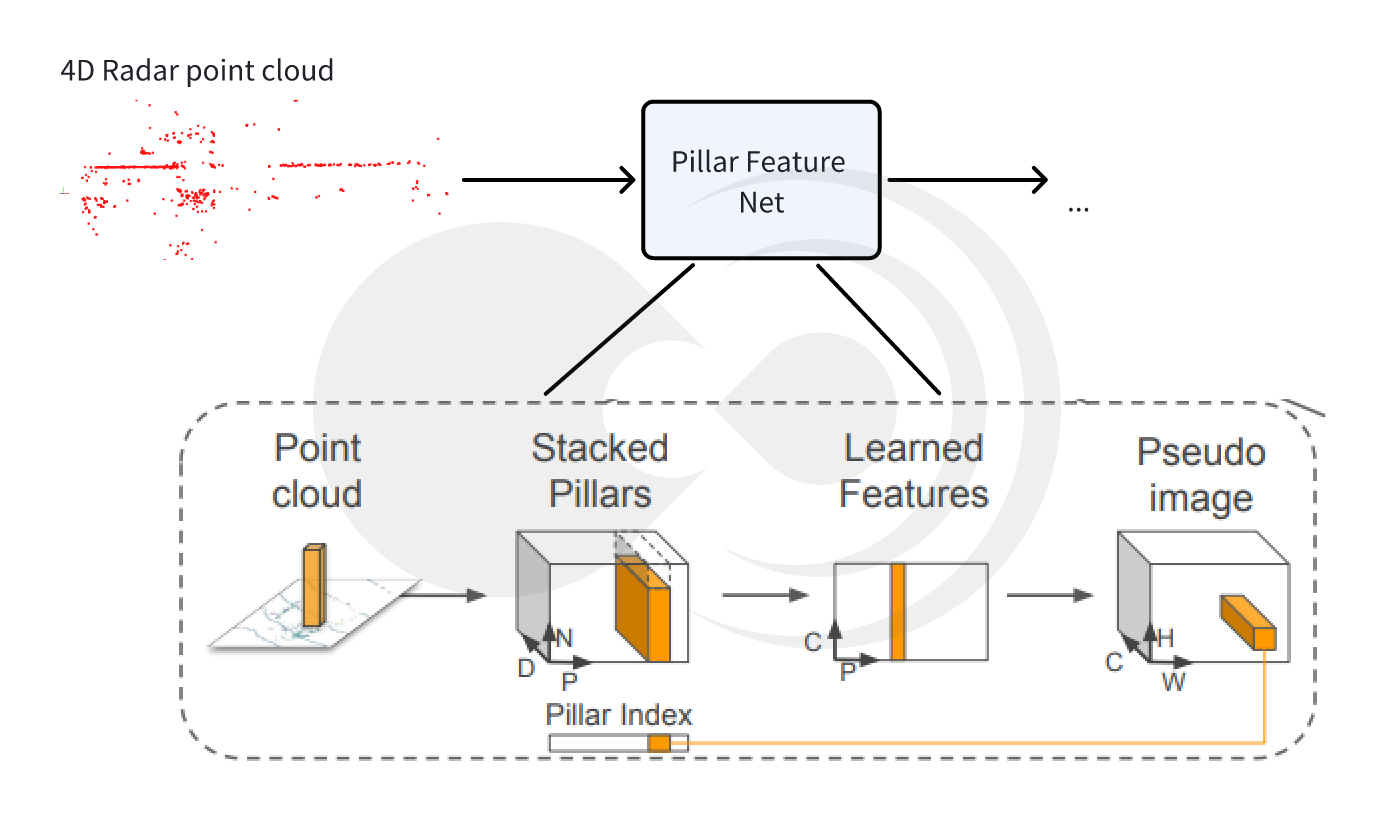

模块使用稀疏点云作为输入,包含3D位置信息,RCS信息,速度信息等。经过PointPillars骨干网络提取点云的局部特征,再经过基于Transformer的骨干网络捕获全局信息。PointPillars可以压缩冗余信息,提取局部特征;RCS编码增强目标检测的性能;Transformer强化关键特征,显著提升稀疏点云的利用率。

PointPillars提取点云局部特征

Pillar Feature Net提取点云特征示意图

采用Pillar编码的方式结构化编码毫米波雷达,将无序的雷达点云划分为规则的“柱状”(Pillar)单元,每个柱体内的点云通过简化特征(坐标、反射强度等)编码为固定维度的特征向量。通过局部特征聚合抑制噪声,保留有效目标信息,有效解决毫米波雷达点云稀疏且包含噪声的问题。针对多目标检测,柱状划分可以有效地捕捉分散的雷达点云(如行人、车辆),提升对小型或远距离目标的检测能力。

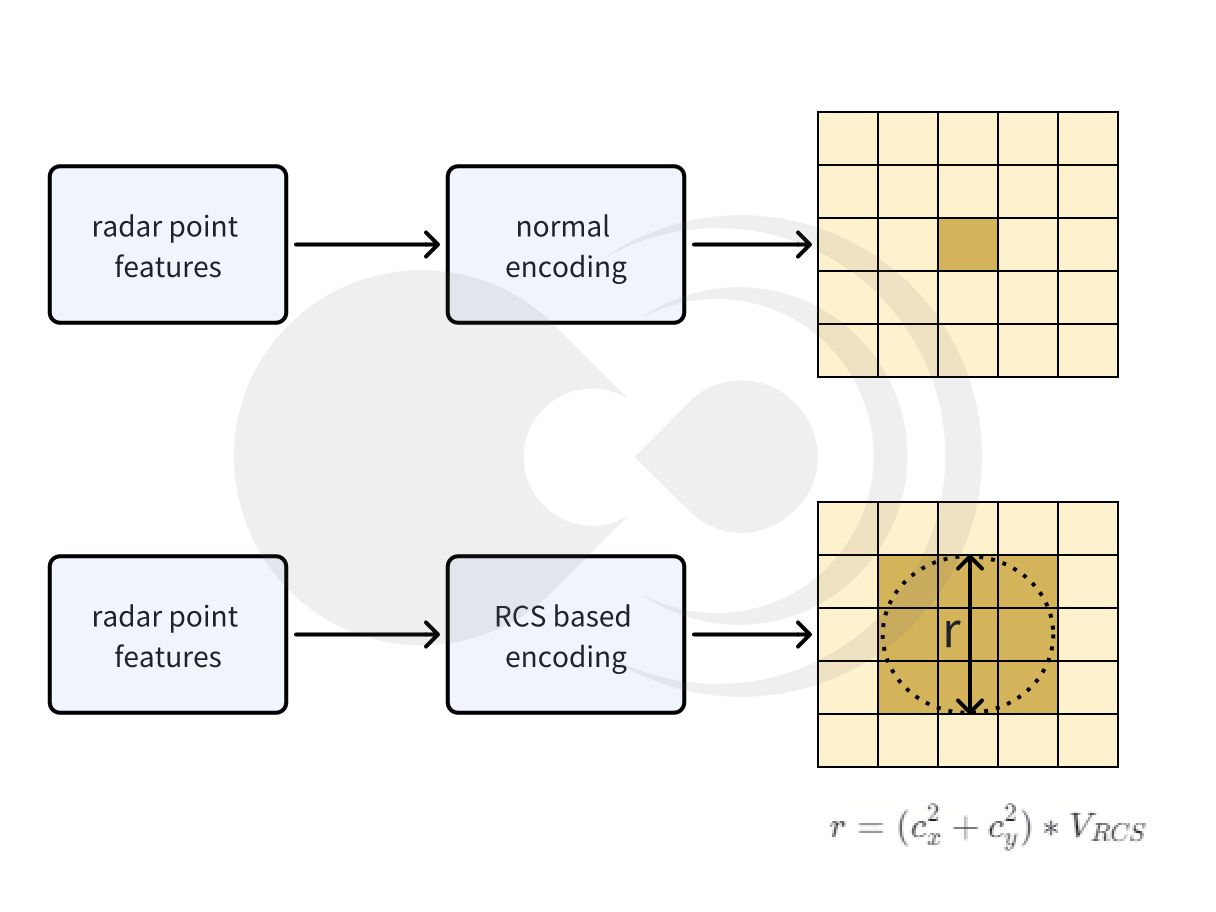

RCS编码提升检测性能

RSC编码示意图

采用基于RCS感知的BEV编码器,利用雷达截面(RCS)能够粗略衡量目标尺寸的特性,有效解决因雷达生成的BEV特征是稀疏的而带来的检测性能损失问题,即利用RCS作为目标尺寸,将一个雷达点的特征分散到BEV空间中的多个像素而不是一个像素。

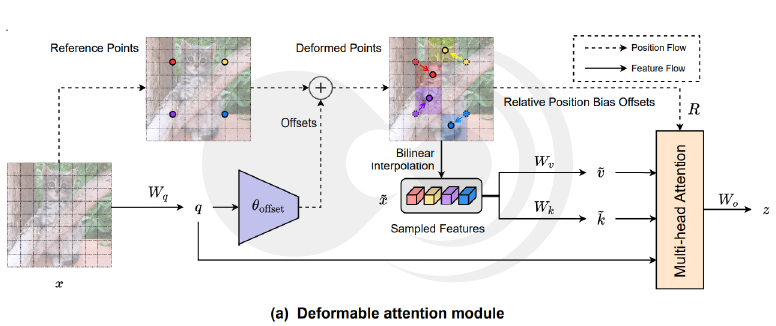

Transformer捕获全局信息

Deformable attention module

(图片来源:《Vision Transformer with Deformable Attention》)

Transformer的子注意力机制可以跨柱体建立关联,捕捉场景中目标之间的空间关系(如车辆与行人的相对位置),弥补传统卷积网络局部感受野的局限。并且采用动态权重分配的策略,根据目标重要性动态调整特征权重,例如在拥堵场景中强化相邻车辆的特征,抑制背景干扰。

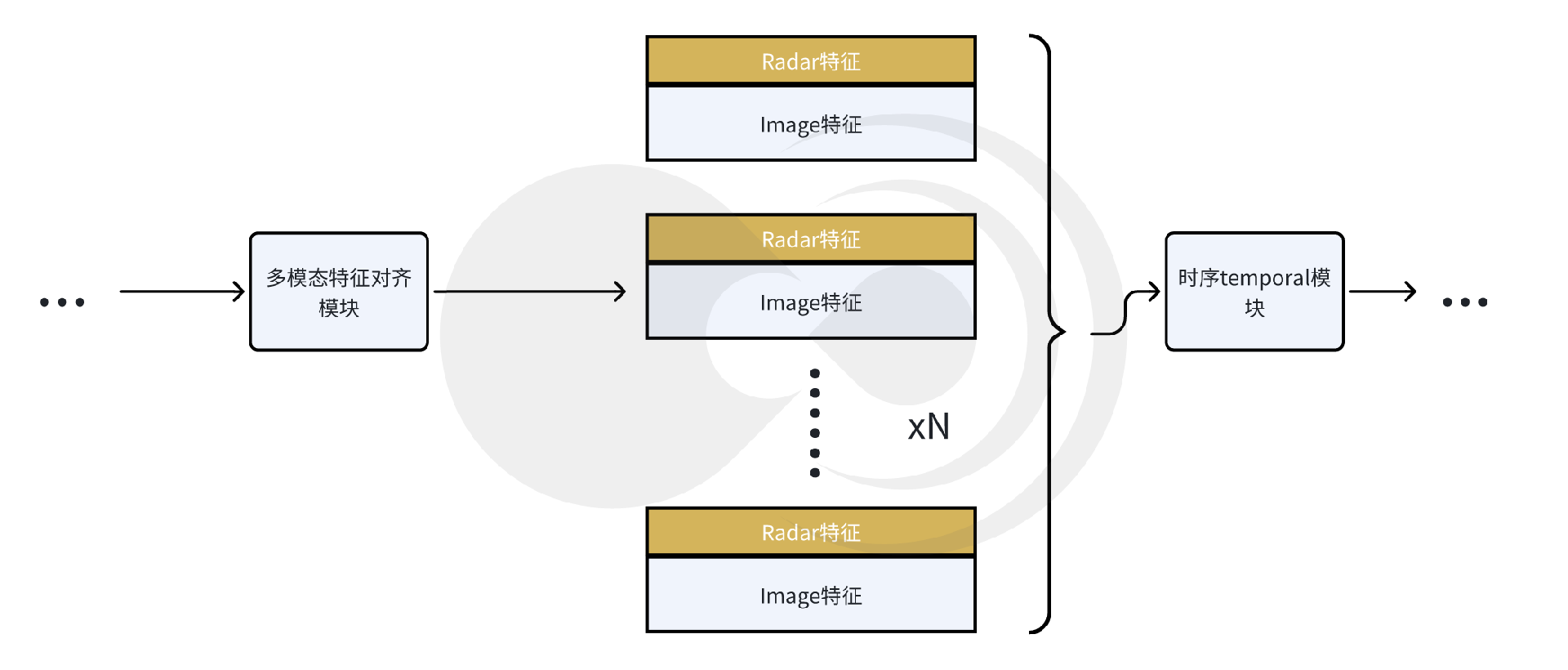

多模态特征对齐时序模块

多模态特征间的对齐问题,一直是影响目标检测优劣的关键因素。

多模态特征对齐时序模块示意图

兼顾算力要求的多模态特征融合对齐

模块通过接收图像特征提取骨干网络的图像特征以及毫米波雷达特征提取骨干网络的雷达特征后,通过多模态特征对齐模块,将二者融合为一体。通过特征拼接,操作计算量极低,能够显著降低硬件的算力要求。并且不对原始特征进行压缩或者变化,保留了特征的原始信息,避免信息丢失,适合需要高保真度的场景。如果需要较强的时序建模能力,且算力资源较为丰富,亦可采用多模态deformable attention的方式来实现对齐。

temporal模块

按照时序添加temporal模块,叠加多帧目标的feature map,能够有效的获取目标的时序信息,大大提升了目标时序特征的准确性和稳定性,如位置、速度等。因采用多帧特征相结合的方式,能够有效提升遮挡目标的检测准确度。

测试指标和结果展示

测试指标说明

模型的测试指标主要通过以下几个方面进行对比:

mAP:mean Average Precision,评估目标检测模型的准确性。它计算每个类别的平均精度(AP),然后对所有类别的AP进行平均,常用于物体检测任务,如COCO数据集评估;

mATE:mean Absolute Trajectory Error,评估物体轨迹预测精度的指标。它计算预测轨迹与真实轨迹之间的绝对误差的平均值,常用于运动预测和计算机视觉中的跟踪任务;

mAVE:mean Average Velocity Error,评估物体速度预测的指标。它计算预测速度与真实速度之间的误差的平均值,常用于动态场景的分析和预测。

结果

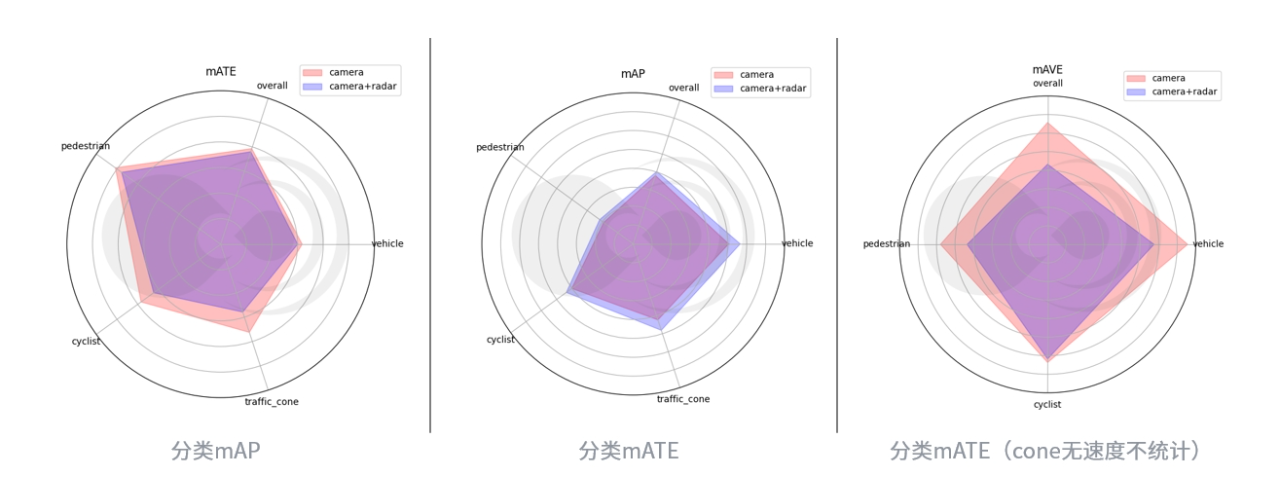

分类测试指标

经过测试,相较于纯视觉模型,4D毫米波雷达相机融合模型,在纵向100米(自车前方),横向+-32米范围内,mAP提升5%,mATE提升2.5%,mAVE提升明显33.85%。

典型场景展示

在许多极端场景下,目标检测的精度,在融合4D毫米波雷达特征后,得到了显著提升。

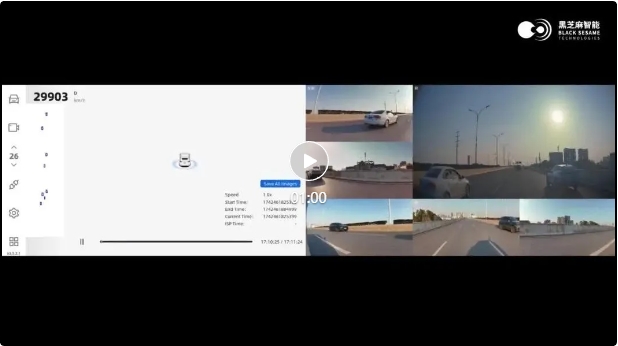

逆光漏检

逆光场景下,由于车辆和背景对比度降低,纯视觉方案难以稳定检测出目标。在融合毫米波雷达的信息后,逆光场景检测率提升12%。

在下述例子中,前方车辆均呈现黑色纹理消失,前前大货车纯视觉方案漏检,若前前车切出,可能因前前车目标位置速度收敛慢,导致自车急刹车,4D-radar利用其回波不受光照影响都特性,顺利补回前方目标。

(0′03″处前前货车丢失补回)

纯视觉模型

4D毫米波雷达相机融合模型

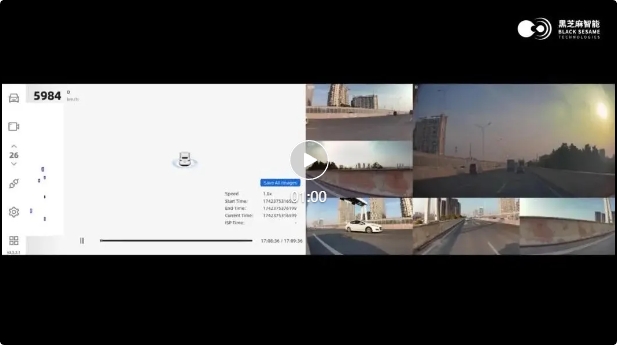

遮挡漏检

在被遮挡的情况下,纯视觉方案难以检测到明确的目标特征,因此可能会导致漏检。在添加毫米波雷达的特征后,能够有效提升遮挡目标的检测率,相比于纯视觉方案,提升7%。

在下述例子中,左侧前方目标由于遮挡导致无法顺利检出,若左侧前方目标向右cut-in自车可能无法及时响应减速。毫米波利用穿透特性,有效实时检测间隔目标,给自车响应预留充足时间。

(0′20″左前方遮挡丢失目标补回)

纯视觉模型

4D毫米波雷达相机融合模型

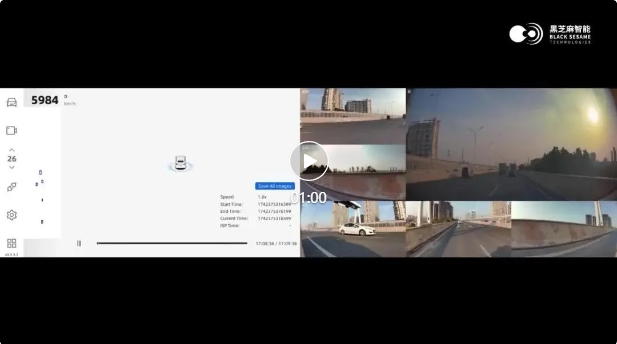

匝道场景

匝道场景下,由于目标和自车可能处于非同平面,纯视觉系统依赖单目或双目相机平面投影模型对目标的位置信息进行估算,易受透视畸变的影响,导致测距测速精度下降。在结合毫米波雷达的3D信息后,在非同平面专项场景下(上下坡场景),目标测距测速准确率提升9%以上。

在下述例子中,下匝道场景4D毫米波雷达相机融合方案将远处货车补回,并输出更加稳定的位置、速度信息。

(0′26″前前货车丢失补回分裂消失)

纯视觉模型

4D毫米波雷达相机融合模型

4D毫米波雷达具有全天候,成本适中,产业链较成熟等特点,目前正在成为行业内多模态融合目标检测任务中的重要传感器。实验结果表明,4D毫米波雷达相机融合方案,相较于纯视觉目标检测方案,有效提升了目标检测的精度,改善了纯视觉模型测距测速的性能,特别是极端场景下模型的表现,如光线局限场景、遮挡场景以及非同平面场景等,提升辅助驾驶的驾驶安全性。